Quand les sciences de l’information aident l’intelligence artificielle

Cerveau, sciences de l’information et intelligence artificielle : voici le triptyque sur lequel Vincent Gripon base ses recherches à Télécom Bretagne. En développant des modèles expliquant comment notre cortex stocke l’information, il entend bien inspirer de nouvelles méthodes d’apprentissage non supervisé. Le 4 octobre prochain, il présentera ses travaux lors d’une conférence organisée par l’Académie des sciences ayant pour objet le renouveau de l’intelligence artificielle. En avant-première, il nous livre un aperçu de sa théorie et des applications qu’elle peut avoir.

Alors que l’intelligence artificielle se développe beaucoup au travers des progrès faits en apprentissage statistique, qu’est ce que cela peut apporter de s’intéresser à la mémoire et au stockage de l’information dans le cerveau ?

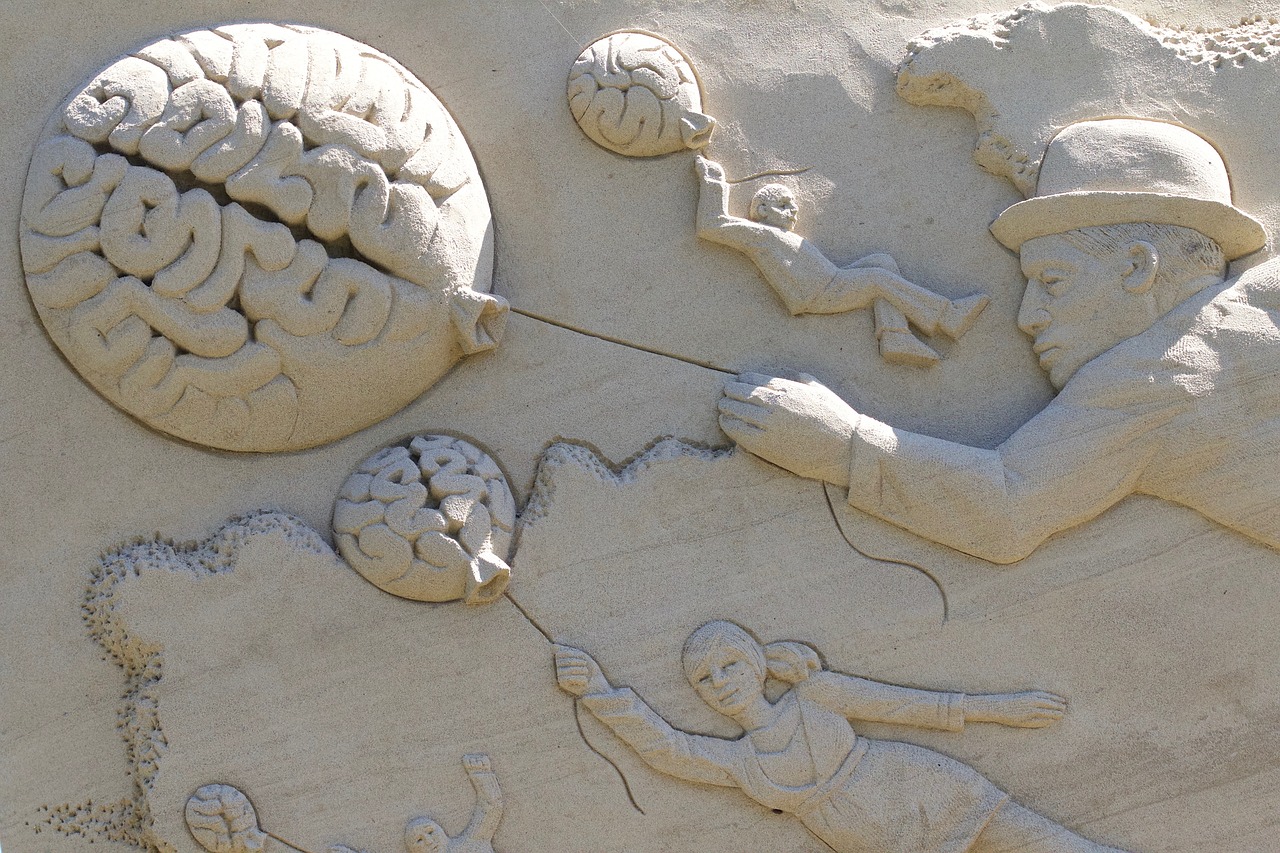

Vincent Gripon : Il y a deux approches de l’intelligence artificielle. La première vient des mathématiques. Elle consiste à formaliser un problème sous l’angle des probabilités et des statistiques, décrivant les objets ou comportements que l’on cherche à inférer comme des variables aléatoires. La seconde est une approche bio-inspirée. Elle consiste à copier le cerveau, en partant du principe qu’il s’agit du seul exemple d’intelligence duquel s’inspirer. Le cerveau n’est pas seulement capable de calculer, il est aussi et surtout capable d’indexer, de rechercher et de croiser des informations. Il est certain que ces aptitudes jouent un rôle fondamental dans toute tâche cognitive, y compris les plus basiques.

Compte tenu de vos travaux, vous considérez que la deuxième approche a plus de chance d’aboutir ?

VG : Après la conférence de Dartmouth de 1956, moment où l’intelligence artificielle a émergé comme domaine de recherche, l’accent a été mis sur l’approche mathématique. 60 ans plus tard, le bilan est mitigé et de nombreux problèmes à la portée d’enfants de 10 ans ne peuvent être résolus à l’aide de machines. C’est en partie ce qui explique la traversée du désert qu’a connu la discipline dans les années 1990. La renaissance que nous constatons depuis quelques années vient du regain d’intérêt pour l’approche des réseaux de neurones artificiels, notamment grâce à l’explosion de la puissance de calcul disponible. Le pragmatisme veut que devant les performances exceptionnelles obtenues aujourd’hui par les méthodes neuro-inspirées, frôlant et dépassant parfois même celles du cortex humain, l’avantage soit donné à ces méthodes.

En quoi la théorie de l’information, habituellement plus tournée vers les codes correcteurs d’erreur en télécommunications que vers les neurosciences, peut vous aider à imiter une machine intelligente ?

VG : En y réfléchissant, le cerveau a la faculté de stocker de l’information, parfois pour de nombreuses années, malgré les aléas permanents auxquels il fait face : pertes de neurones et de connexions, communications ultra bruitées… Des problèmes très similaires se posent dans les systèmes numériques, notamment du fait de la miniaturisation et de la multiplication des composants. La théorie de l’information propose un paradigme permettant de traiter les problèmes du stockage et du transfert de l’information, et s’applique à tout système, biologique ou non. La notion d’information est par ailleurs essentielle à toute forme d’intelligence, tout comme celle de calcul, bien plus souvent mise en avant.

Sur quel modèle vous basez-vous ?

VG : En tant que théoricien de l’information, je pars du principe qu’une information robuste est une information redondante. Appliquer ce principe au cerveau nous invite à considérer que l’information est stockée à l’échelle de plusieurs neurones, voire de plusieurs micro-colonnes, qui sont des amas de neurones, sur le modèle des codes correcteur d’erreurs distribués. Un modèle offrant une très grande robustesse est celui des cliques. Une clique est composée de plusieurs — disons au moins quatre — micro-colonnes, toutes reliées entre elles. L’avantage de ce modèle est que même si une connexion est perdue, toutes peuvent encore communiquer. C’est une propriété typique de la redondance. Par ailleurs, deux micro-colonnes peuvent être impliquées dans plusieurs cliques. Ainsi, toute connexion sous-tend plusieurs informations, et toute information est portée par plusieurs connexions.

Cette double propriété permet d’assurer à la fois la grande robustesse et la grande diversité de stockage du mécanisme.

Comment la communauté spécialiste du cerveau reçoit-elle cette théorie ?

VG : Il est très difficile de faire des ponts entre le médical et les sciences mathématiques ou informatiques. Nous n’avons pas le même vocabulaire ni les mêmes intentions. Il est par exemple complexe de faire admettre à nos collègues neuroscientifiques que l’information peut être stockée dans la structure même des connexions du réseau neuronal, et non dans ses poids. La meilleure façon de communiquer reste l’imagerie biomédicale, où les modèles se confrontent à la réalité, permettant parfois d’en faciliter la lecture.

Les observations réalisées en imagerie vous donnent-elles de l’espoir concernant la validité de vos théories ?

VG : Nous collaborons en particulier avec le laboratoire de traitement du signal et de l’image (LTSI) de l’université de Rennes I pour valider nos modèles. Pour les mettre en évidence, l’activation cérébrale de sujets réalisant des tâches cognitives est observée par le biais de l’électroencéphalographie. Il ne s’agit pas de validations directes de nos théories, la résolution spatiale requise pour y arriver étant aujourd’hui hors d’atteinte, mais de vérifications de propriétés macroscopique qu’elles prédisent. Par exemple, une des conséquences du modèle des cliques neurales est qu’il existe une corrélation positive entre la distance topologique des représentations d’objets dans le néocortex et la distance sémantique entre ces mêmes objets. Plus exactement, les représentations de deux objets similaires partageront un grand nombre de micro-colonnes. Cela se confirme en imagerie. Certes, cela ne valide pas la théorie, mais peut nous conduire à l’amender ou à mener de nouvelles expérimentations pour la mettre à l’épreuve.

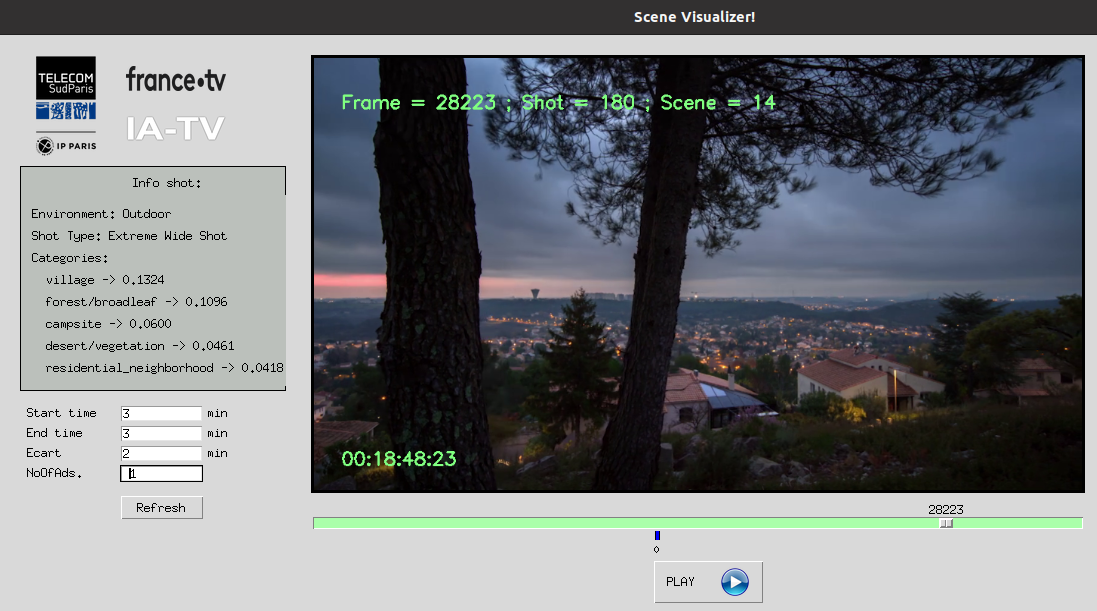

Dans quelle mesure votre modèle est-il utilisé en intelligence artificielle ?

VG : Nous nous plaçons sur des problèmes liés à l’apprentissage machine — typiquement sur de la reconnaissance d’objets. Notre modèle offre de bons résultats en particulier dans le cadre d’apprentissages non supervisés, c’est à dire sans qu’un expert humain n’aide l’algorithme à apprendre en lui indiquant ce qu’il doit trouver. Comme nous nous intéressons à la mémoire, nous visons des applications différentes de ce qui se fait d’habitude dans le domaine. Par exemple, nous nous intéressons de près à la capacité d’un système artificiel à apprendre avec peu d’exemples, à apprendre beaucoup d’objets différents ou encore à apprendre au fil de l’eau, découvrant de nouveaux objets plus tard que d’autres. Notre approche est donc complémentaire, plus qu’en concurrence avec d’autres méthodes d’apprentissage.

L’état de l’art en intelligence artificielle est aujourd’hui axé sur les réseaux de neurones artificiels — ce qui est appelé « deep learning ». Comment vous positionnez-vous en complément de cette méthode d’apprentissage ?

VG : Les réseaux de neurones profonds atteignent aujourd’hui des performances exceptionnelles, comme le met en lumière un nombre croissant de publications scientifiques. Ils restent toutefois limités dans certains contextes. Par exemple, ils demandent une énorme quantité de données pour être efficaces. De même, lorsqu’un réseau de neurones est entraîné, il est très difficile de lui faire prendre en compte de nouveaux paramètres. Grâce à notre modèle, nous sommes capables d’autoriser un apprentissage incrémental : si un nouveau type d’objet apparaît, nous pouvons l’apprendre à un réseau déjà entrainé. Pour résumer, notre modèle est moins bon pour faire du calcul et de la classification, mais meilleur pour la mémorisation. Un réseau de clique a donc toute sa place aux côtés d’un réseau de neurones profond.

Vous pouvez également visionner la vidéo de la conférence :

Pour aller + loin : La conférence de Vincent Gripon à l’Espace des sciences de Rennes

[divider style= »solid » top= »5″ bottom= »5″]

![]()

L’intelligence artificielle à l’Académie des sciences

Parce que l’intelligence artificielle allie aujourd’hui des approches inspirées de nombreux champs scientifiques, l’Académie des sciences organise le 4 octobre prochain une conférence baptisée « intelligence artificielle : le renouveau ». Au travers des présentations de quatre chercheurs, cet évènement présentera des facettes diverses de la discipline. En plus de Vincent Gripon et de sa présentation alliant neurosciences informationnelles et intelligence artificielle, la conférence accueillera Andrew Blake (Alan Turing Institute) pour parler des machines apprenantes, Yann LeCun (Facebook, New York University) sur l’apprentissage profond, et Karlheinz Meier (université de Heidelberg) au sujet des architectures d’ordinateurs dérivées du cerveau.

Infos pratiques :

Conférence « Intelligence artificielle : le renouveau »

4 octobre 2016 à 14h00

Grande salle des séances de l’Institut de France

23, quai de Conti, 75006 Paris

Inscriptions obligatoires avant le 3 octobre

[divider style= »solid » top= »5″ bottom= »5″]

Trackbacks (rétroliens) & Pingbacks

[…] Quand les sciences de l’information aident l’intelligence artificielle […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !