Sans bruit, le virtuel devient un peu plus réel

Avec l’augmentation des capacités de calcul, les images de synthèse deviennent de plus en plus réalistes. Cependant, leur génération demande énormément de temps. Pour résoudre ce problème, l’équipe de Tamy Boubekeur, spécialisée en informatique graphique 3D à Télécom ParisTech, a développé une nouvelle technologie. Elle s’appuie sur des algorithmes de réduction du bruit et permet d’économiser des ressources de calcul tout en garantissant une qualité d’image à la pointe.

Avez-vous déjà été bluffé par la qualité d’un film d’animation ? Si vous êtes familier des cinématiques de jeux vidéo ou des courts-métrages en images de synthèse, probablement. Et si vous ne l’êtes pas, souvenez-vous que les tournages des derniers Star Wars et autres Animaux Fantastiques ne se déroulent pas dans une véritable superstructure satellite de la taille d’une lune ou en présence d’authentiques bêtes magiques. Les décors et personnages de ces films à gros budgets sont en grande partie des modélisations 3D d’une qualité confondante. Un exemple de prouesse graphique parmi tant d’autres : la démonstration faite par l’équipe du moteur de jeu vidéo Unreal Engine lors de la Game Developers Conference de San Francisco en mars dernier. En collaboration avec Nvidia et ILMxLAB, elle a créé une scène fictive de Star Wars entièrement en images de synthèse, des décors aux personnages.

Pour tromper le spectateur, le maître-mot est la qualité du rendu. Un domaine dont Tamy Boubekeur et son équipe de Télécom ParisTech sont spécialistes. Aujourd’hui, la plupart des animations de qualité sont réalisées par un type de synthèse d’image : la synthèse photoréaliste par tracé de chemins. Avec cette méthode, tout commence par une modélisation en 3D de la scène voulue, avec les structures, les objets, et les personnages. Puis, les sources de lumière sont placées dans la scène artificielle : soleil pour l’extérieur, ou lampes pour l’intérieur. Ensuite, des chemins sont tracés depuis la caméra — c’est-à-dire l’œil du spectateur, ce qui est affiché sur l’écran — et remontent jusqu’à la source de lumière. Ces chemins sont ceux empruntés par la lumière qui se réfléchit sur les différents objets et personnages de la scène. Au fil des réflexions, les modifications que subit la lumière sont associées à chaque pixel de l’image.

« Ce principe s’appuie sur les lois de la physique et sur le principe de réciprocité de Helmholtz, ce qui permet de « remonter la lumière » depuis le capteur virtuel » présente Tamy Boubekeur. À chaque rebond sur les entités qui composent la scène, les équations régissant le comportement de la lumière et les propriétés des matériaux et des surfaces modélisées définissent la suite du chemin. La propagation de la lumière ainsi modélisée permet de capturer toutes les altérations et effets optiques que percevrait l’œil dans une véritable situation. « Chaque pixel de l’image est la fin de centaines, voire de milliers de chemins empruntés par la lumière dans la scène simulée » souligne le chercheur. La moyenne des réponses couleurs portée par chaque chemin donne alors la couleur du pixel.

Gagner du temps sans faire de bruit

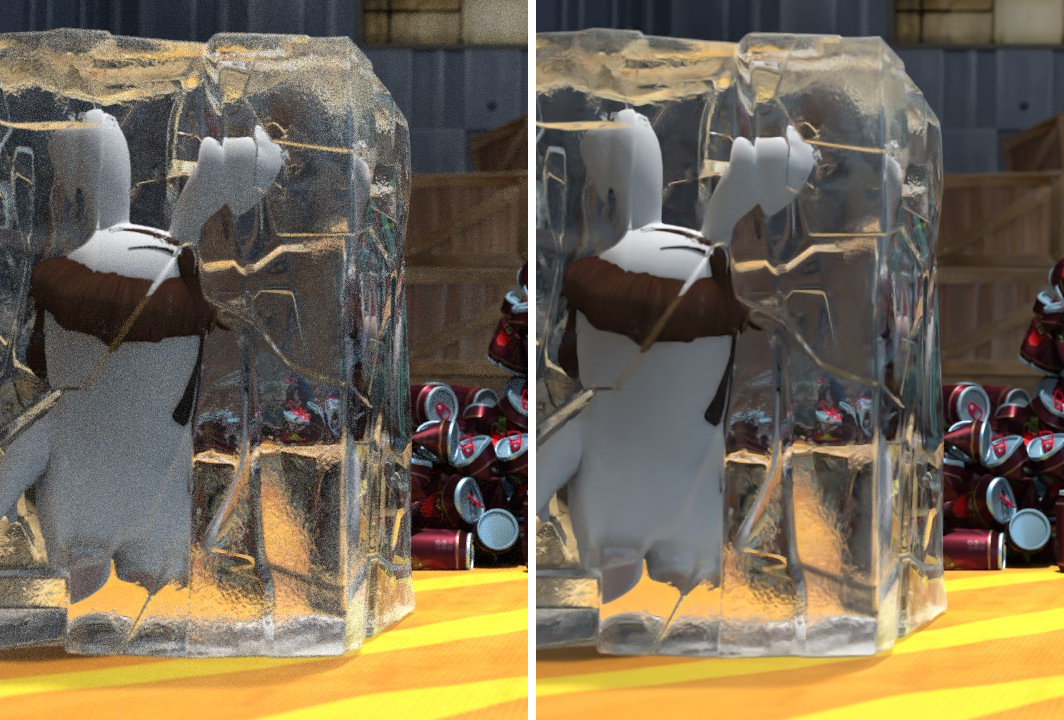

Le problème, c’est qu’il faut énormément de chemins pour avoir un rendu vraiment réaliste. « Certaines scènes demandent des milliers de chemins par pixel et par image : il faut une semaine de calculs pour générer l’image sur un ordinateur standard ! » pointe Tamy Boubekeur. Trop long. Trop coûteux. Un film demande 24 images par seconde. En une année de calcul, à peine plus de deux secondes de films seraient produites sur une unique machine. C’est là qu’entrent en jeu les algorithmes de réduction du bruit, et notamment ceux mis au point par l’équipe de Télécom ParisTech. « Le principe, c’est d’arrêter les calculs bien avant d’atteindre les milliers de chemins » détaille le chercheur. « Comme nous ne sommes pas allés suffisamment loin dans la simulation, l’image est bruitée, et d’autres algorithmes sont alors chargés de supprimer ce bruit. » Le bruit altère la netteté d’une image et dépend de la nature de la scène, de ses matériaux, de l’éclairage et de la caméra virtuelle.

Depuis 2011, les travaux de recherche sur le bruitage ont émergé et se sont multipliés. Aujourd’hui, de nombreux algorithmes existent, avec des approches plus ou moins différentes. La concurrence est rude pour offrir des résultats satisfaisants. Dans la balance des performances : la capacité des programmes à faire économiser un maximum de temps de calcul, et le rendu final en matière de suppression du bruit. À ce jeu, la technologie Bayesian collaborative denoiser (BCD) mise au point par l’équipe de Tamy Boubekeur est particulièrement efficace. Développés entre 2014 et 2017 lors de la thèse de Malik Boudiba, les algorithmes de cette technologie sont basés sur une approche originale.

D’habitude, les méthodes de débruitage essaient de deviner à partir des propriétés de la scène observée — notamment de sa géométrie visible — la quantité de bruit présent en un pixel pour ensuite le supprimer. « Nous avons considéré que les propriétés de la scène observée n’expliquaient pas tout » présente Tamy Boubekeur. « Le bruit provient également de zones non-visibles de la scène, de la suite de matériaux ayant réfléchi la lumière, de volumes semi-transparents traversés par elle ou bien encore des propriétés de l’optique modélisée au sein de la caméra virtuelle. » Un arrière-plan en défocus, ou une vitre au premier plan vont en effet causer un bruit plus ou moins important dans l’image. Pour sa part, l’algorithme BCD ne prend donc en compte que les valeurs de couleurs associées aux centaines de chemins calculés jusqu’à l’arrêt de la simulation, juste avant que ces valeurs ne soient moyennées en une couleur pixel. « À partir de la distribution de ces valeurs, notre modèle estime le bruit associé au pixel en analysant les similarités avec les propriétés d’autres pixels, et les débruite tous à la fois, d’un coup » poursuit le chercheur.

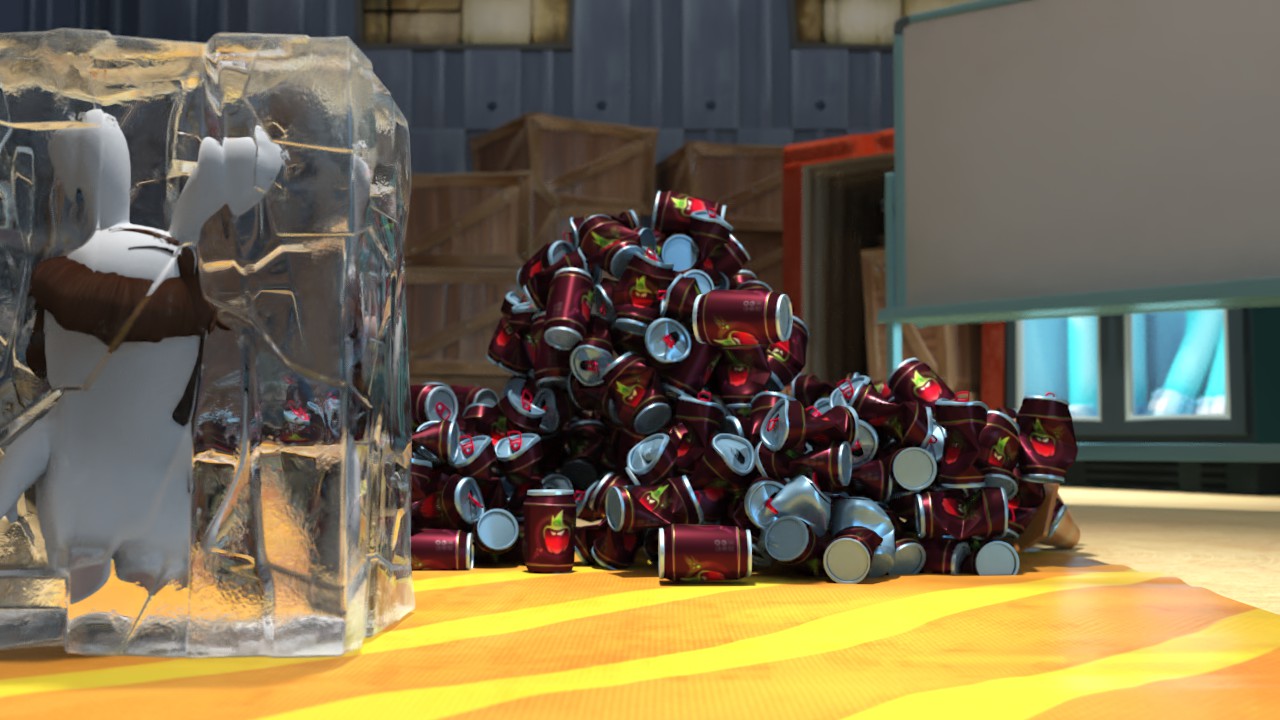

Des lapins crétins mais bien nets

La technologie BCD a été développée au sein du projet PAPAYA lancé dans le cadre du Fonds national pour la société numérique. Il a été mené en partenariat avec Ubisoft Motion Pictures pour définir les problématiques de réduction du bruit rencontrées dans le milieu professionnel de l’animation. Les algorithmes de la technologie BCD ont particulièrement plu à l’entreprise puisqu’elle les a déployés sur son moteur graphique de production, Shining, et les a utilisés pour la réalisation de sa série d’animation Les lapins crétins. « Ce qui leur a plu, c’est que nos algorithmes fonctionnent pour tout type de scène, et que la technologie se déploie sans intrusion » rapporte Tamy Boubekeur. Le débruiteur BCD ne demande pas de changer les méthodes de calcul des images, et s’implante facilement dans des systèmes et des équipes disposant d’outils déjà bien rôdés.

Le code source de la technologie a été publié en open source sur Github. Il est accessible librement, notamment aux professionnels des films d’animation qui préfèrent utiliser des technologies ouvertes que des technologies propriétaires moins flexibles. Une mise à jour du code intègre également un module de prévisualisation interactive qui permet d’ajuster les paramètres de l’algorithme et d’optimiser alors plus facilement ses ressources de calcul.

La technologie BCD a fait ses preuves, et est aujourd’hui intégrée à plusieurs moteurs de rendu. Elle représente une opportunité d’accéder à de la synthèse d’images de qualité avec des ressources plus modestes. Tamy Boubekeur rappelle qu’un film comme Les nouveaux héros de Disney, comportant environ 120 000 images, demande 200 millions d’heures de calcul et nécessite des milliers de processeurs pour être produit en un temps raisonnable. Pour les étudiants et artistes amateurs, ces moyens techniques sont inatteignables. Toutefois, des algorithmes comme ceux de la technologie BCD leur laissent l’espoir de produire des films de très bonne qualité plus facilement. Et pour réduire encore plus les heures de calcul requises, l’équipe de Télécom ParisTech continue ses recherches. En ligne de mire : de nouvelles méthodes de distribution du calcul de simulation de la lumière sur un très grand nombre de machines aux faibles capacités.

[divider style= »normal » top= »20″ bottom= »20″]

Illustration du débruitage BCD sur une scène avant application de l’algorithme, et après.

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !